--關注回複“40429”--

--領取《汽車駕駛自動化分級》(GB/T 40429-2021)--

感覺系統基本介紹

Perception(感覺)系統是以多種傳感器的資料與高精度地圖的資訊作為輸入,經過一系列的計算及處理,對自動駕駛車的周圍環境精确感覺的系統。

它能夠為下遊子產品提供豐富的資訊,包括障礙物的位置、形狀、類别及速度資訊,也包括對一些特殊場景的語義了解(例如施工區域,交通信号燈及交通路牌等)。

感覺系統的構成與子系統

傳感器:涉及到傳感器的安裝,視場角,探測距離,資料吞吐,标定精度,時間同步等。因為自動駕駛使用的傳感器比較多,時間同步的解決方案至關重要。

目标檢測及分類:為了保證自動駕駛的安全,感覺系統需要達到近似百分之百的召回率及非常高的準确率。目标檢測及分類往往會涉及到深度學習方面的工作,包括3D點雲及2D Image(圖檔)上的物體檢測及多傳感器深度融合等。

多目标追蹤:跟進多幀的資訊計算并預測障礙物的運動軌迹。

場景了解:包括交通信号燈,路牌,施工區域,以及特殊類别,比如校車,警車。

機器學習分布式訓練基礎架構及相關評價系統

資料:大量的标注資料,這裡包括3D點雲資料及2D的圖檔資料等。

傳感器詳解

目前自動駕駛應用的傳感器主要分為三類:雷射雷達(LiDAR),相機(Camera),毫米波雷達(Radar)。

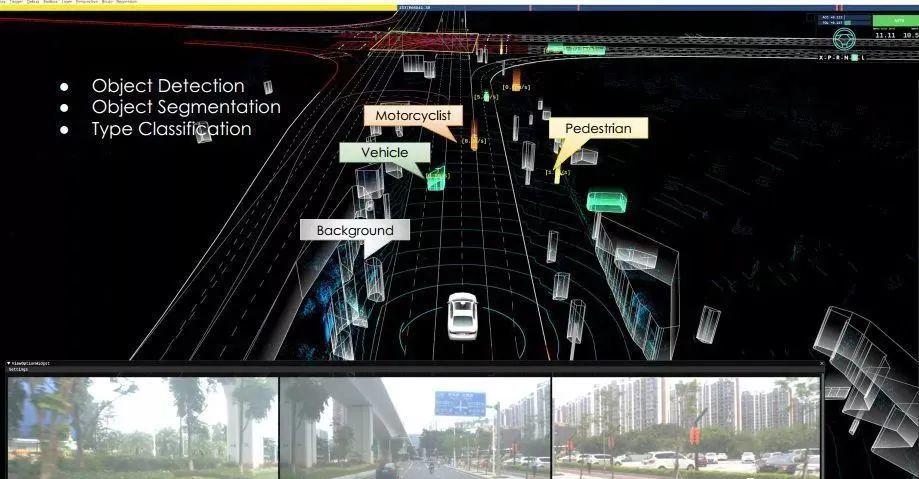

開頭提到,感覺系統的輸入為多種傳感器資料和高精地圖,而上圖展示了感覺系統物體檢測的輸出結果,即能夠檢測車輛周圍的障礙物,如車輛、行人、自行車等,同時結合高精度地圖,感覺系統也會對周邊的Background(環境背景)資訊進行輸出。

如上圖所示,綠顔色的塊狀代表一輛乘用車,橙色代表一輛機車,黃色代表一位行人,灰色則是檢測到的環境資訊,如植被。

感覺系統結合多幀的資訊(上圖),還能對運動的行人和車輛的速度、方向、軌迹預測等進行精确的輸出。

傳感器配置與多傳感器深度融合

了解了關于感覺系統從輸入到輸出的大緻介紹,接下來,我簡要介紹一下小馬智行第三代自動駕駛系統PonyAlpha的傳感器安裝方案以及多傳感器深度融合的解決方案。

傳感器安裝方案

目前PonyAlpha傳感器安裝方案的感覺距離能夠覆寫車周360度、範圍200米以内。

具體來看,這套方案用到了3個雷射雷達,在車的頂部和兩側。同時,通過多個廣角的攝像頭來覆寫360度的視野。遠處的視野方面,前向的毫米波雷達以及長焦相機将感覺距離擴到200米的範圍,使其可以探測到更遠處的物體資訊。這套傳感器配置能保證我們的自動駕駛車輛在居民區、商業區、工業區這樣的場景進行自動駕駛。

多傳感器深度融合解決方案

多傳感器深度融合的基礎

多傳感器深度融合的方案首要解決的是将不同的傳感器的資料标定到同一個坐标系裡,包括了相機的内參标定,雷射雷達到相機的外參标定,毫米波雷達到GPS的外參标定等等。

傳感器融合重要前提是使标定精度達到到極高水準,不論對于結果層面的傳感器融合還是中繼資料層面的傳感器融合,這都是必要的基礎。

通過上圖你會發現,我們的感覺系統将3D的雷射點雲精準地投射到影像上,可見傳感器标定的精度是足夠高的。

不同傳感器的标定方案

整個傳感器标定的工作基本上已做到完全自動化的方式。

首先是相機内參的标定(上圖),這是為了修正由相機自身特性導緻的圖像扭曲等。相機内參的标定平台使每一個相機能夠在兩到三分鐘之内完成傳感器的标定。

其次是雷射雷達與GPS/IMU的外參标定(上圖),雷射雷達的原始資料是基于雷達坐标系,是以我們需要将點由雷達坐标系轉換為世界坐标系,這就涉及到雷射雷達與GPS/IMU相對位置關系的計算。我們的标定工具在室外通過優化的方案,能夠快速找到最優的位置關系。

第三是相機到雷射雷達的融合(上圖)。雷射雷達的感覺環境是360度旋轉的方式,每旋轉一周是100毫秒,而相機是某一瞬時曝光,為了保證相機的曝光與雷射雷達的旋轉保證同步,需要對二者進行時間同步,即通過Lidar來觸發相機曝光。比如說,可以通過雷射雷達的位置資訊來觸發對應位置相機的曝光時間,以達到相機與雷射雷達的精确同步。

3D(雷射雷達)和2D(相機)彼此互補,二者更好的融合可使得感覺得到更精确的輸出。

最後是毫米波雷達(Radar)與GPS/IMU的标定(上圖),同樣是将Radar資料由Local(本地)坐标系将其轉換到世界坐标系,我們将通過真實的3D環境來計算Radar與GPS/IMU的相對位置關系。好的标定結果能夠保證感覺系統給出200米距離以内障礙車的車道資訊(如位于車道内或壓車道線等)等。

下面這個demo視訊簡明生動地展示了多傳感器深度融合的部分處理效果。

車載感覺系統架構

那麼車載感覺系統架構是什麼樣的?它的解決方案又是什麼?

上圖展示了整個車載感覺系統的架構。首先雷射雷達、相機、毫米波雷達三種傳感器資料須進行時間同步,将所有的時間誤差控制在毫秒級。結合傳感器資料,感覺系統以幀為基礎(frame-based)進行檢測(detection)、分割(segmentation)、分類(classification)等計算,最後利用多幀資訊進行多目标跟蹤,将相關結果輸出。這個過程中将涉及到多傳感器深度融合和深度學習相關的技術細節,我這裡不做過多的讨論。

感覺系統的解決方案應保證以下五點

◆ 首先是安全,保證近乎百分之百的檢測(Detection)召回率(Recall)。

◆ 精度(Precision)要求非常高,如果低于某個門檻值,造成False Positive(誤報),會導緻車輛在自動駕駛狀态下行駛得非常不舒适。

◆ 盡量輸出所有對行車有幫助的資訊,包括路牌,交通信号燈及其它場景了解的資訊。

◆ 保證感覺系統的高效運作,能夠近實時處理大量的傳感器資料。

◆ 可擴充性(Scalability)也很重要。深度學習(Deep learning)依賴大量資料,其訓練模型的泛化能力對于感覺系統非常重要。未來,我們希望模型(model)和新算法有能力适配更多的城市和國家的路況。

感覺技術的挑戰

感覺精度與召回率相平衡的挑戰

上圖展示了晚高峰時期十字路口的繁忙場景,此時有大量行人、機車穿過十字路口。

通過3D點雲資料(上圖),能夠看到此時對應的感覺原始資料。

這裡挑戰是,經過計算處理後,感覺系統需要在這樣環境下輸出所有障礙物的正确的分割(segmentation)結果和障礙物類别。

除了繁忙的十字路口,感覺系統在處理一些特殊的或者惡劣的天氣條件,也面臨不小挑戰。

突降暴雨或者長時間降雨往往會造成路面積水,車輛經過自然會濺起水花。上方視訊中白色點雲展示了雷射雷達檢測到其他車輛經過濺起的水花并對其進行filter(過濾)的結果。如果感覺系統不能對水花進行準确的識别和過濾,這會對自動駕駛造成麻煩。結合雷射雷達與攝像頭(Lidar&Camera)的資料,我們的感覺系統對水花有很高的識别率。

長尾場景挑戰

灑水車

上圖是我們在路測時曾遇到的兩類灑水車(上圖)。左邊灑水車采用向上噴的霧炮,而右邊是向兩側噴灑的灑水車。

人類司機遇到灑水車時,可以很容易做出判斷并超過灑水車,但是對于感覺系統來說,則需要花一定時間去處理和識别這類場景和車輛,我們的自動駕駛在遇到類似場景已獲得更優的乘坐體驗。

小物體的檢測

小物體檢測的意義在于,面對意想不到的路測事件,比如流浪的小貓、小狗突然出現馬路上,感覺系統對這類小物體能夠有準确的召回,以保證小生命的安全。

紅綠燈

随着越來越多地區和國家開展自動駕駛路測,感覺系統在處理交通信号燈總會遇到新的長尾場景。

例如,逆光的問題(上圖)或者突然從橋洞中駛出後相機曝光的問題,我們可以通過動态調整相機的曝光等方法來解決問題。

還有紅綠燈倒計時的場景(上圖),感覺系統可以識别出倒計時的數字,這樣能夠讓自動駕駛車輛在遇到黃燈時/前,給出更優的規劃決策應對,優化乘車體驗。

雨天時,攝像頭(照相機)會水珠密布(上圖),感覺系統需要處理這類特殊氣候條件下的場景,準确識别紅綠燈。

一些地區使用的紅綠燈帶有進度條(上圖),要求感覺系統能夠識别進度條的變動,這樣可以幫助下遊的規劃決策子產品在綠燈将變黃時,提前給出減速。

轉載自智車科技,文中觀點僅供分享交流,不代表本公衆号立場,如涉及版權等問題,請您告知,我們将及時處理。

-- END --